Какую роль могут занять децентрализованные GPU-сети в сфере ИИ

Децентрализованные сети GPU продвигают себя как более дешевый уровень для запуска ИИ-нагрузок, тогда как обучение самых передовых моделей по-прежнему сосредоточено в гипермасштабных дата-центрах.

Обучение «фронтирных» моделей ИИ — это создание крупнейших и самых сложных систем, где тысячи GPU должны работать в строгой синхронизации.

Такая степень согласованности делает децентрализованные сети малопригодными для топового обучения: задержки и надежность интернета не могут конкурировать с тесно связанной инфраструктурой централизованных дата-центров.

При этом большая часть ИИ в реальной эксплуатации не похожа на масштабное обучение моделей — и здесь появляется пространство для децентрализованных сетей, которые могут брать на себя инференс и повседневные задачи.

Сооснователь и CEO Theta Network Митч Лю отметил, что многие модели с открытым исходным кодом и другие решения становятся достаточно компактными и оптимизированными, чтобы эффективно работать на потребительских GPU. По его словам, это ускоряет переход к более экономичным подходам обработки и более эффективным моделям.

От обучения передовых моделей к повседневному инференсу

Обучение передовых моделей сконцентрировано у нескольких гипермасштабных операторов: крупные обучающие прогоны дороги и сложны в организации. Новейшее «железо» для ИИ, включая Nvidia Vera Rubin, проектируется так, чтобы максимально раскрывать производительность именно внутри интегрированных дата-центров.

Глава инфраструктурной компании Ovia Systems (ранее Gaimin) Нёккви Дан Эллидасон сравнил обучение таких моделей со строительством небоскреба: в централизованном дата-центре «рабочие стоят на одних лесах и передают кирпичи из рук в руки».

По его словам, при таком уровне интеграции почти не остается места для слабой координации и переменной задержки, характерных для распределенных сетей.

Если же пытаться «строить небоскреб» в децентрализованной сети, «кирпичи пришлось бы пересылать друг другу через открытый интернет», что крайне неэффективно, добавил он.

Meta обучала модель Llama 4 на кластере более чем из 100 000 GPU Nvidia H100. OpenAI не раскрывает размер кластеров для обучения своих моделей, однако руководитель инфраструктуры Ануй Сахаран сообщал, что GPT-5 запускали при поддержке более 200 000 GPU — без уточнения, какая часть мощности шла на обучение, а какая на инференс и другие задачи.

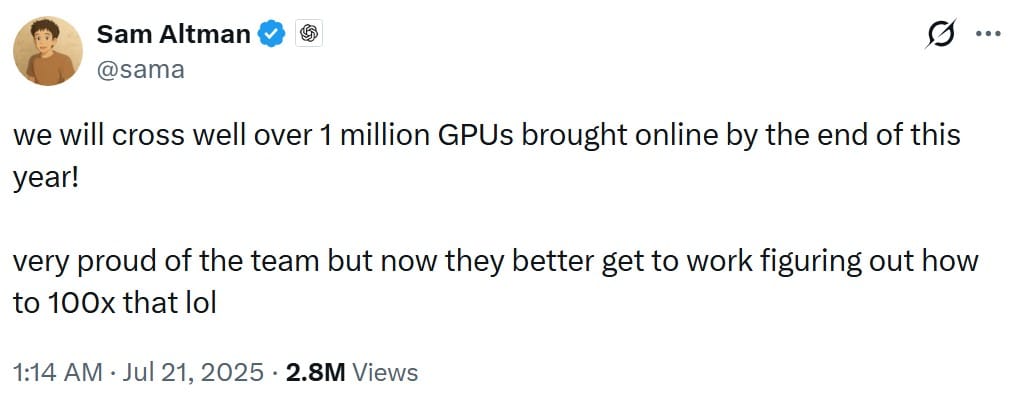

Инференс — это запуск уже обученных моделей для выдачи ответов пользователям и приложениям. Эллидасон считает, что рынок подошел к «переломному моменту инференса»: если еще в 2024 году спрос на GPU во многом определяло обучение, то к 2026 году, по его оценке, до 70% спроса дают инференс, агенты и задачи прогнозирования.

Он также подчеркнул, что вычисления превращаются из разового исследовательского расхода в постоянную масштабируемую «коммунальную» статью затрат, а это делает децентрализованные вычисления уместными в гибридных схемах.

Где децентрализованные GPU-сети действительно полезны

Лучше всего децентрализованные GPU-сети подходят для задач, которые можно дробить, маршрутизировать и выполнять независимо — без постоянной синхронизации между машинами.

Сооснователь платформы децентрализованных вычислений Fluence Евгений Пономарев отмечает, что инференс — это «бизнес на объемах», который растет вместе с каждой внедренной моделью и каждым контуром агентных сценариев. По его словам, здесь важнее цена, эластичность и географическое распределение, чем идеальные межсоединения.

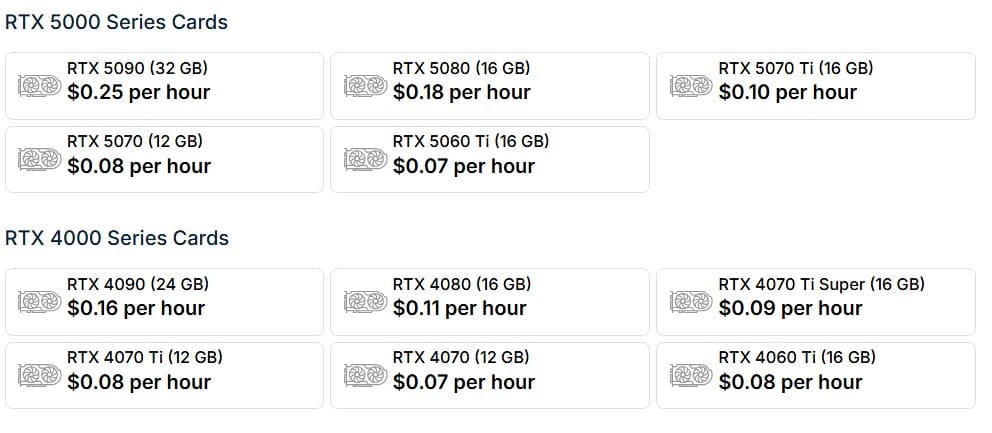

На практике это означает, что децентрализованные сети и «игровые» потребительские GPU лучше подходят для продакшн-нагрузок, где ключевыми являются пропускная способность и гибкость, а не жесткая координация.

CEO Salad Technologies Боб Майлз (компания агрегирует простаивающие потребительские GPU) пояснил, что видеокарты с меньшим объемом VRAM и домашним интернетом плохо подходят для обучения или задач, чувствительных к задержкам.

По его словам, сейчас они больше подходят для ИИ в разработке лекарств, генерации текста в изображения/видео и крупных конвейеров обработки данных — для всего, где критична стоимость: потребительские GPU выигрывают по соотношению цена/производительность.

Также децентрализованные GPU-сети удобны для сбора, очистки и подготовки данных под обучение: такие процессы часто требуют широкого доступа к открытому вебу и хорошо распараллеливаются без жесткой координации.

Майлз добавил, что в гипермасштабных дата-центрах подобную работу сложно делать эффективно без развитой прокси-инфраструктуры.

При обслуживании пользователей по всему миру децентрализованный подход может дать географическое преимущество: он уменьшает расстояния, которые проходят запросы, и число сетевых «прыжков» до дата-центра, что влияет на задержки.

Лю из Theta Network отметил, что в децентрализованной модели GPU распределены по множеству локаций и часто находятся ближе к конечным пользователям, поэтому задержка между пользователем и GPU может быть заметно ниже, чем при маршрутизации трафика в централизованный дата-центр.

Также сообщается, что в декабре 2025 года в Лос-Анджелесе двое бывших сотрудников подали иск против Theta Network, заявив о мошенничестве и манипуляциях токеном. Лю сказал, что не может комментировать ситуацию из-за продолжающегося судебного разбирательства, а ранее компания отрицала обвинения.

Дополняющий уровень в ИИ-вычислениях

Обучение самых передовых моделей ИИ в обозримом будущем останется централизованным, но фокус вычислений смещается к инференсу, агентам и производственным задачам, где допустима более «свободная» координация. В таких сценариях выигрывают экономичность, географическая распределенность и эластичность.

Технический директор Theta и сооснователь компании Цзеи Лун отметил, что в текущем цикле выросло число open-source моделей, которые не достигают масштаба систем уровня ChatGPT, но достаточно сильны, чтобы работать на домашних ПК с GPU вроде RTX 4090 или 5090.

По его словам, с таким уровнем «железа» пользователи могут локально запускать диффузионные модели, модели 3D-реконструкции и другие полезные нагрузки, что создает возможность для владельцев видеокарт делиться GPU-ресурсами.

В итоге децентрализованные GPU-сети не заменяют гипермасштабных провайдеров, но все больше становятся дополнительным уровнем.

По мере роста возможностей потребительского оборудования и повышения эффективности open-source моделей все более широкий класс ИИ-задач может выходить за пределы централизованных дата-центров, позволяя децентрализованным решениям занять свое место в вычислительном стеке.

Источник информации: dc.finance